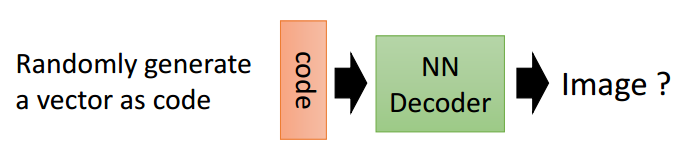

VAE

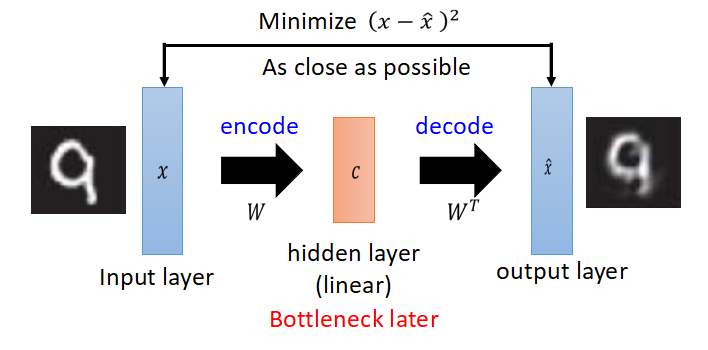

PCA

PCA的解释:原向量x乘以矩阵W得到中间编码c,再乘以W的转置,得到x head,得到的x head希望与原x越接近越好,有一点要注意,从x到c的变换过程是线性的。

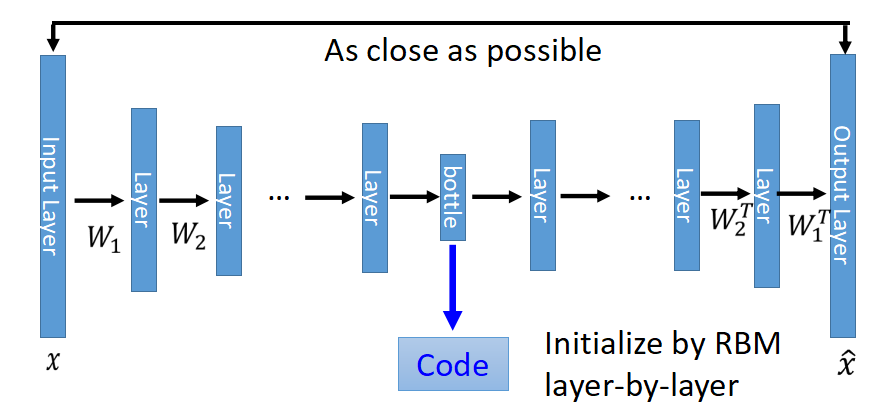

Deep Auto Encoder

和PCA类似,只是网络层数更深,变换是非线性的(因为可以加入一些非线性的激活函数),Deep Auto Encoder变成成了如下的样子:

中间有个很窄的hidden layer的输出就是压缩之后的code,当然以bottle layer对称的W不必要互为转置,也不要求一定要用RBM初始化参数,直接train,效果也很好。

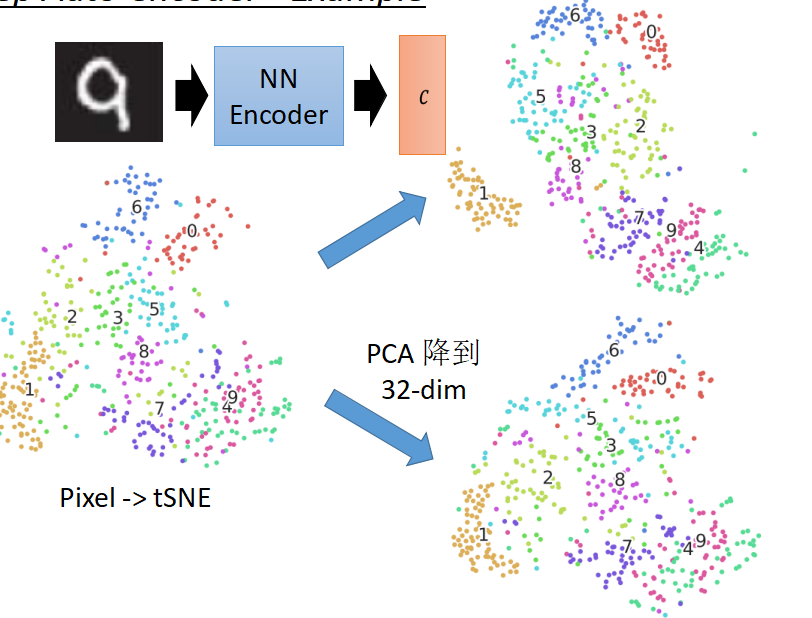

下面来看一下,对于MNIST手写数字数据集用像素点、PCA、Deep Auto Encoder三种方式分别做tSNE的展现图

右上角为deep auto encoder之后做tSNE,所有的数字都分的很开,效果比较好。

总结一下,PCA和Deep auto encoder所做的事都类似,就是把原数据压缩到一个低维向量,让后再反解回来,反解回来的值希望与原来的值越接近越好。

PCA像是比较基础,然后Deep auto encoder像是对PCA进行魔改

Auto Encoder用于异常检测

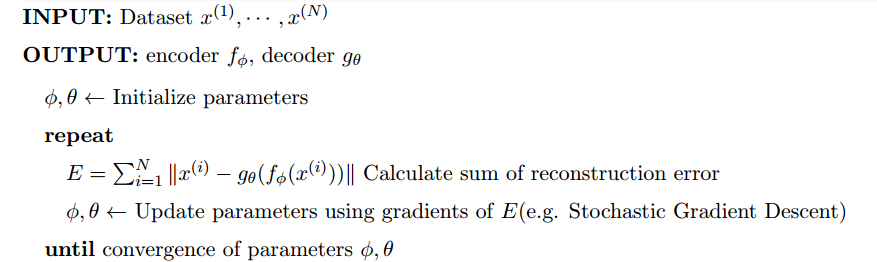

对于自动编码器用于异常检测,可以参考《Variational Autoencoder based Anomaly Detection using Reconstruction Probability》这篇论文 ,论文地址:http://dm.snu.ac.kr/static/docs/TR/SNUDM-TR-2015-03.pdf ,论文标题大概可以这样翻译:基于变分自动编码器重建概率的异常检测。 文中不是直接从变分自动编码器切入,而是先介绍自动编码器,论文言简意赅,我们先来看看论文中对Auto Encoder的训练过程的描述

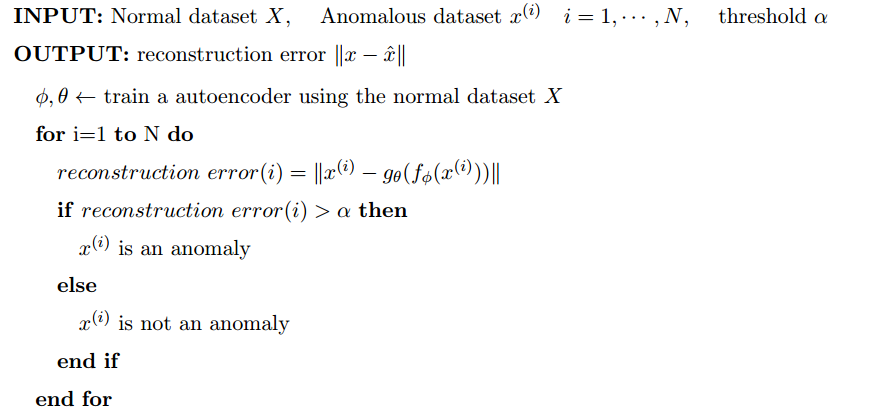

下面来看,如果将Auto Encoder用于异常检测,还是先看公式

就是先训练一个encode,然后进行推理,得到loss,然后反向传播

说明:

- 先用正常的数据集训练一个Auto Encoder

- 用训练出的Auto Encoder计算异常数据的重建误差,重建误差大于某个阀值α,则为异常,否则则正常。

文中有这样一段描述:

Autoencoder based anomaly detection is a deviation based anomaly detection method using semi-supervised learning. It uses the reconstruction error as the anomaly score. Data points with high reconstruction are considered to be anomalies.Only data with normal instances are used to train the autoencoder

这段描述指出了两点:

1、半监督,用正常的数据训练一个Auto Encoder

2、重建误差高的数据为异常数据

普通Deep Auto Encoder有个缺陷,通俗的话来讲就是模型看过的类似的数据它知道,模型没看过的数据,几乎不可能能知道,那变分编码器,就可能解决了一部分问题,通过用分布相似来解释这个问题,请看下面的公式:

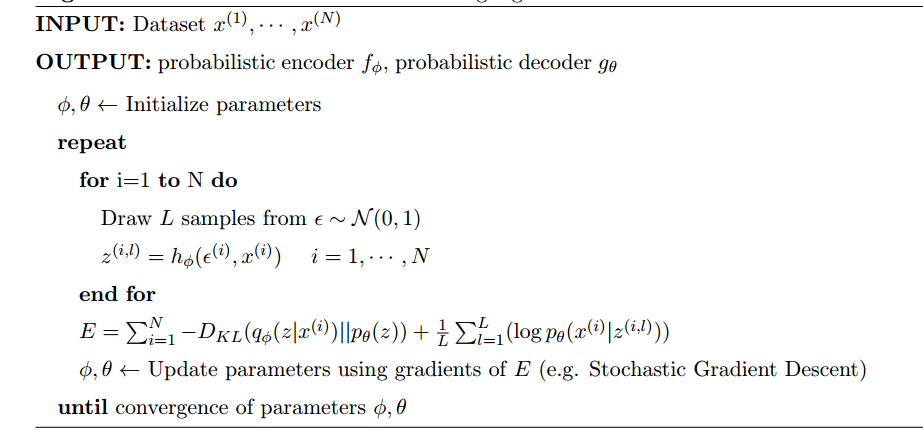

训练:

补充E等式右边第一项知识:博客连接

qφ(z | x)是近似后验,pθ(z)是潜在变量z的先验分布。论文翻译

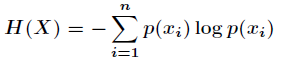

今天开始来讲相对熵,我们知道信息熵反应了一个系统的有序化程度,一个系统越是有序,那么它的信息熵就越低,反之就越高。下面是熵的定义

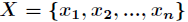

如果一个随机变量X的可能取值为

,对应的概率为

,则随机变量X的熵定义为

有了信息熵的定义,接下来开始学习相对熵。

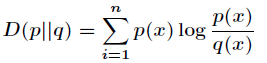

相对熵的认识 相对熵又称互熵,交叉熵,鉴别信息,Kullback熵,Kullback-Leible散度(即KL散度)等。设p(x)和q(x) 是X取值的两个概率概率分布,则p对q的相对熵为

在一定程度上,熵可以度量两个随机变量的距离。KL散度是两个概率分布P和Q差别的非对称性的度量。KL散度是用来度量使用基于Q的编码来编码来自P的样本平均所需的额外的位元数。 典型情况下,P表示数据的真实分布,Q表示数据的理论分布,模型分布,或P的近似分布。2. 相对熵的性质 相对熵(KL散度)有两个主要的性质。如下

(1)尽管KL散度从直观上是个度量或距离函数,但它并不是一个真正的度量或者距离,因为它不具有对称性,即  (2)相对熵的值为非负值,即

- 说人话,就是

Dkl叫KL散度,第一项是用来衡量距离的一种指标

整个训练的过程用通俗的话说明一下,首先从标准正态分布中随机L个数据和原x经过hφ函数后得到隐含变量z,注意这里是为每一个样本x都随机L个数据来生成z,loss函数告诉我们两件事情:

第一件,希望z的分布和给定了x的条件下z的分布越接近越好

第二件,希望给定了z的条件下反解回来的x和原分布越接近越好。本质上而言,VAE是给原x加上了随机噪声,同时希望可以反解回原来的值

中间隐含变量就非常神奇了,可以是高斯分布,也可以是伯努利分布,用概率分布来编码,在自动生成中有妙用。 推理:

原文博主的一些思考(搬):

论文中只给出了可以这样做以及这样做的效果,但是论文中没有解释为什么这样做。

其实这个问题比较好类比,训练数据都是正常的,就好比一个人生活的圈子里只有猫,突然来了一条狗,他就肯定不认识了,只知道和猫不同,那么通过数学中的线性回归来类推一下,根据一批正常点拟合了一条直线,有一个游离于这个群体的点,自然离这条直线很远。同样的可以用数据边界来解释,神经网络见过了大量的正常数据,便学习到了数据的边界,游离于边界外的数据,自然也可以摘出来。

但是同样有一个问题,既然原始样本集里已经有正常数据和异常数据了,通过有监督训练一个分类模型就够了。但是真实的场景里,我们是不知道怎么标注数据的,如果说可以标注,肯定是基于人工指定的规则,既然有了规则,就基于规则写if else(这里是针对数据维度比较小的场景)了,何必要机器来学习,但是规则制定的是否正确还两说,比方说金融领域常见的风险评估,某个用户是否可以放贷给他,已知该用户的各种信息,例如:年龄、性别、职业、收入、信用卡账单等等,这里只是举一个小例子。

以上的疑问,总结起来就两点

1、如何标注数据,到底是先有鸡还是先有蛋

2、基于定死的规则标注的数据是否正确可用

那么,能不能完全无监督的让机器学习出识别这些异常数据的规则,我觉得通过Auto Encoder是可以做到的,首先,对于异常识别的场景,正常的样本数肯定占大多数,异常的只是少数,把整个样本集完全扔给Deep Auto Encoder,让他去学习,同样可以找出异常数据。

个人总结

对比来看三种算法

- PCA:简单地进行降维采样,让低纬度的参数去学习“生成原始数据”的方法

- Deep Auto Encoder:对PCA进行拓展魔改,由原来单纯的线性变换拓展为非线性,对称拓展为非对称,并且可以自己设置中间的维度变换过程

- VAE:在前面的基础上,随机加入噪声,使得模型能够有较好的泛化性